2016年是人工智能發展歷程中一個具有里程碑意義的年份。這一年,基礎軟件開發取得了顯著進展,不僅推動了AI技術的普及與應用,也為后續的爆發式增長奠定了堅實的基礎。

一、開源框架的興起與生態構建

2016年,開源人工智能框架呈現出百花齊放的態勢。Google發布的TensorFlow 1.0版本正式推出,憑借其靈活的架構、強大的分布式計算支持以及豐富的工具鏈,迅速成為工業界和學術界最受歡迎的深度學習框架之一。與此Facebook主導的PyTorch雖然尚未正式發布1.0版本,但其動態計算圖的特性吸引了大量研究人員的關注,為后續的快速發展埋下伏筆。微軟也通過CNTK框架展示了其在深度學習基礎設施上的實力。這些開源框架的競爭與合作,極大地降低了AI開發的門檻,促進了全球開發者的協作與創新。

二、算法與模型庫的豐富化

在基礎軟件層面,2016年見證了眾多經典算法的實現與優化。以計算機視覺為例,ResNet、Inception-v3等模型通過開源框架得以廣泛傳播與應用。自然語言處理領域,Word2Vec、GloVe等詞向量技術成為標準配置,而基于LSTM和GRU的序列模型在各類任務中表現出色。強化學習庫如OpenAI Gym的發布,為算法測試與比較提供了標準化環境,推動了深度強化學習研究的快速發展。

三、開發工具鏈的完善

為了提高開發效率,2016年AI基礎軟件開發工具鏈得到了顯著加強。可視化工具如TensorBoard的出現,使得研究人員能夠直觀地監控訓練過程、分析模型結構。自動化超參數調優工具開始萌芽,盡管尚未成熟,但已顯示出減少人工干預的潛力。模型部署工具也逐漸受到重視,例如TensorFlow Serving的推出,幫助開發者將訓練好的模型高效地部署到生產環境中。

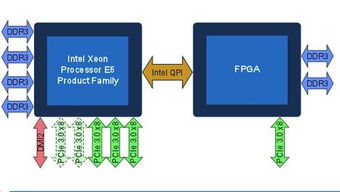

四、硬件與軟件的協同優化

隨著GPU在深度學習訓練中的普及,2016年的基礎軟件開發更加注重與硬件的協同優化。CUDA深度神經網絡庫(cuDNN)不斷更新,提供了高度優化的底層原語,大幅提升了訓練速度。各大框架也加強了對多GPU并行訓練的支持,使得處理更大規模數據集和更復雜模型成為可能。針對嵌入式設備和移動端的輕量級推理框架開始嶄露頭角,為AI技術的端側部署鋪平道路。

五、社區與教育資源的蓬勃發展

2016年,圍繞AI基礎軟件開發的社區生態迅速壯大。GitHub上相關項目的星標數快速增長,在線論壇和社交媒體上的討論日益活躍。眾多高質量的教程、在線課程和技術博客涌現,幫助新手快速入門。高校與研究機構也紛紛開設相關課程,將最新的工具與實踐引入課堂。這種知識共享的氛圍,加速了AI技術的傳播與創新。

六、挑戰與展望

盡管成就斐然,2016年的AI基礎軟件開發仍面臨一些挑戰。不同框架之間的兼容性問題、模型的可復現性、大規模分布式訓練的穩定性等,都是亟待解決的難題。如何讓軟件更好地適應多樣化的硬件環境,如何提高開發調試的效率,也需要持續探索。

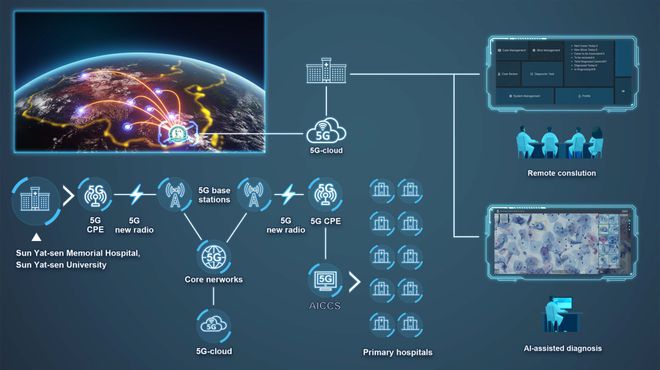

2016年的進展為AI基礎軟件的發展指明了方向:更加易用的接口、更強大的性能、更完善的生態。這些努力不僅推動了人工智能技術的民主化,也為后續在自動駕駛、醫療診斷、智能助理等領域的應用突破提供了堅實支撐。

2016年是人工智能基礎軟件開發承前啟后的關鍵一年。通過開源協作、工具創新與生態建設,開發者社區共同構建了更加繁榮的技術 landscape,為人工智能的黃金時代拉開了序幕。